이번에도 regression에서 했던 것 처럼 함수를 만든 것의 cost를 알아봐야겠죠?

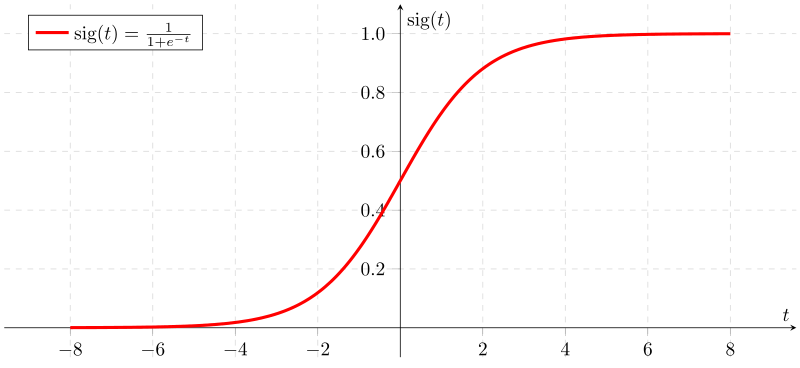

근데 이 sigmoid 함수가 좀 이상하게 생겼습니다.

linear regression는 일자 선으로 나와서 편했는데, 얘는 구불구불해요

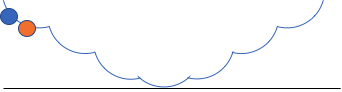

그래서 얘의 cost function을 그려보면 아래와 같이 생긴게 아니라

아래와 같이 조금 구불구불하게 생겼습니다.

그러면 여기서 경사하강법을 사용한다고 가정해보면

위의 파란점에서 시작하면 주황색 점이 cost가 가장 적은 곳이라고 판단할 수도 있습니다.

그래서 이런 형태의 cost 함수를 사용합니다.

얘를 그려보면 아래와 같이 됩니다.

그래서 얘를 수식으로 정리하면 아래와 같은 애가 됩니다.

얘를 이용해서 학습을 시킵니다.

참조

[1] - https://www.youtube.com/watch?v=6vzchGYEJBc&list=PLlMkM4tgfjnLSOjrEJN31gZATbcj_MpUm&index=12

[2] - https://www.youtube.com/watch?v=BQEhUD2XTaA&t=1601s

'유튜브 > 대충 배우는 머신러닝 AI(영상삭제)' 카테고리의 다른 글

| 13 - multinomial logistic classification (0) | 2020.02.14 |

|---|---|

| 12 - logistic classification 실습 (0) | 2020.02.13 |

| 10 - Logistic Classification (0) | 2020.02.10 |

| 9 - regression kaggle 실습 (0) | 2020.01.31 |

| 8 - regression 실습2 (0) | 2020.01.31 |